伴随着4G和5G通信技术的发展,消费者拥有了更便捷的移动网络体验,加之便携相机和智能手机等视频采集设备的普及,视频数据极易获取,且在互联网上呈指数级增长趋势。

对这些视频数据进行标注是现阶段智能推荐和智能安全防控等业务的重要过程。

但对这个量级的数据进行人工标注成本过高,且标注速度赶不上视频数据的产生速度,如果可以根据视频自身结构特点进行预学习,不仅可以减少标注的投入,还可以进行快速业务上线,为后续产品调整提供帮助。这对商业和学术领域都具有深远意义。

此外,这些标注信息只能体现数据在标签层的语义,而非视频数据的特有序列结构特征。但视频中的相邻帧有很强的相关性和冗余性,同一视频在具体模式上不同的采样帧序列间是语义一致的。合理的利用这一特性,不仅可以减小人工标注的成本,而且可以更高效的提取视频中视觉特征。

现有的基于对比学习视频自监督学习方法主要通过扩展基于图像对比学习方法,只进行一定数量帧的空域的对比增强学习,以有效的利用视频数据的上述特性,无需进行额外标注,即可进行深度网络训练,进而服务下游的视频理解任务。

但这种直接扩展基于图像对比学习方法,存在以下问题:

1.忽略视频本身的结构特性,只对每帧进行单独的处理,忽略了帧间语义关联。

2.由于只是扩展基图像的方法,并没有在视频角度下的进行多视角学习,无法高效的挖掘视频特征信息,且无法保证应用与不同视频源。

因此,考拉悠然科技提供一种基于图对比增强的视频自监督表征学习方法。

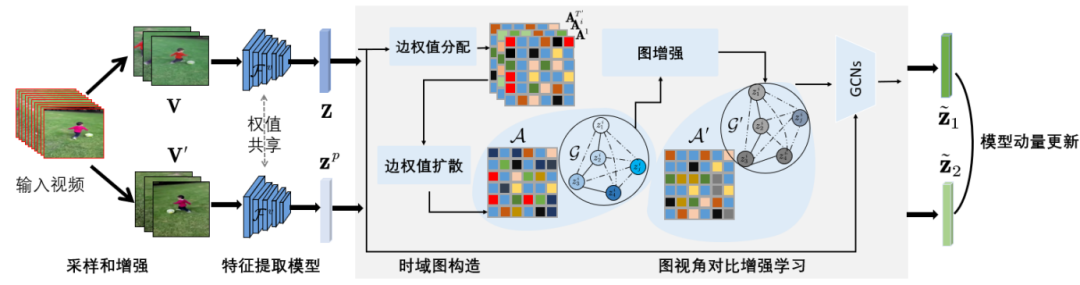

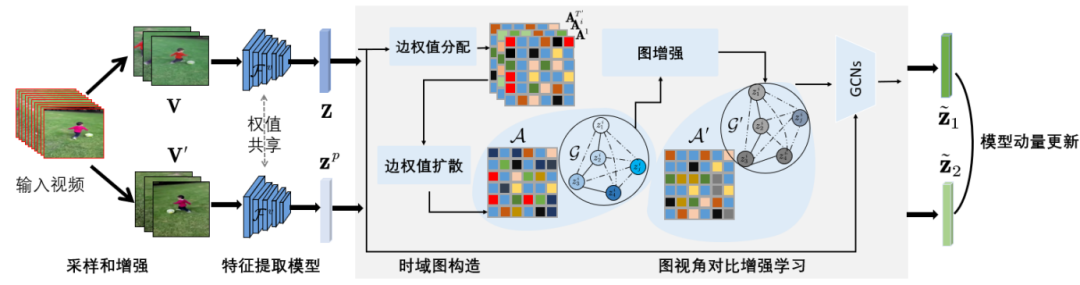

如下图所示,在图像领域对比学习的基础上,扩展成序列帧的情形并合理利用相邻帧间的相关性。

该方法设计了一个新颖的基于图对比增强的视频表征学习方法。具体地,提出一种构建时域图方法和设计一种在该时域图基础上进行图数据增强方法,以高效的利用视频中帧相关性特性来进行视频帧序列对比学习。利用视频时序关联性进行时域图建模,然后提出新颖的图视角进行视频表征学习,视频在该图视角下可以完整的保留结构特性;最终,利用记忆存储机制进行模型优化。

基于图对比增强的视频自监督表征学习方法框架图

具体地,该方法可分为如下几步:

1.首先对大规模的无标签视频数据集中的视频进行采样和空域数据增强,以得到视频的两种帧序列表示,并对采样和经过图像增强处理后的视频序列运用卷积网络进行特征提取;

2.在提取后的特征序列表征基础上构建T-跳时域图,并对图中边实施权值分配和权值扩散;

3.对时域图基础上进行图视角的对比增强,在时域图中扰动融合邻接矩阵的边和节点进行图视角的增强变换,得到增强邻接矩阵;

4.在增强时域图的基础上,对增强处理后的序列特征进行图卷积推理,以充分融合不同层次特征;

5.采用增强特征序列对视频自监督表征提取模型进行训练和优化,得到训练好的视频自监督表征提取模型,具体采用利用模型动量更新机制进行训练。

基于该视频表征模型的先验,将某个领域或任务上学习到的知识或模式应用到不同但相关的领域或问题中,进行实际场景下少样本数据学习,以快速的部署到该场景下。

考拉悠然科技研发团队所开发的例如吸烟识别、玩手机识别、打架识别等各个场景算法,在预训练模型的基础上,仅需少量视频样本进行动作特征提取注册,就可以进行后续视频流动作实时识别。该应用设计了一个新颖视频动作识别方法,具体地,先以注册的机制将动作的特征和相应的ID注册到行为库中,识别过程中将实时视频的特征与库中的特征进行比对验证,并输出动作ID。模型在只有少量数据情况下具有快速学习的能力并识别新的实体。

在未来,考拉悠然科技还将持续探索深耕,开发出更多场景下的视频分析能力。